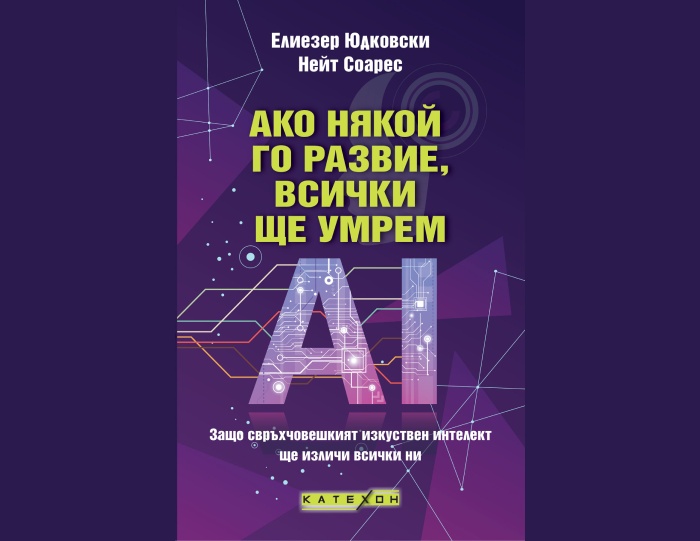

Създаването на свръхчовешки изкуствен интелект ни доведе на пътя към изчезване. Все още не е късно да сменим курса според двама от най-ранните изследователи в тази област в книгата-призив към човечеството.

През 2023 г. стотици изтъкнати учени в областта на изкуствения интелект подписаха отворено писмо, в което предупреждават, че ИИ може да доведе до изчезването на човечеството. Оттогава надпреварата в областта на изкуствения интелект само се засили. Компании и държави се надпреварват да създадат машини, които ще бъдат по-умни от всеки човек – а светът е ужасно неподготвен за това, което ще последва.

В продължение на десетилетия двама от подписалите писмото – Елиезер Юдковски и Нейт Соарес – изучават как ще мислят, ще се държат и ще преследват целите си интелектите, които са по-умни от човека. Изследванията им сочат, че достатъчно умните ИИ ще развият собствени цели, които ще доведат до конфликт с нас; и че ако се стигне до конфликт, изкуственият свръхинтелект ще ни унищожи. Състезанието дори няма да е оспорвано.

Как една машина със свръхинтелект би могла да унищожи целия ни биологичен вид? Защо би искала да го направи? Би ли искала изобщо нещо? В тази много важна книга Юдковски и Соарес разглеждат теорията и доказателствата, представят един възможен сценарий за изчезване и обясняват какво е необходимо, за да оцелее човечеството.

Светът се състезава да създаде нещо наистина ново под слънцето. И ако някой го развие – всички ще умрем.

„Може да се окаже най-важната книга на нашето време.“ – Тим Ъбан

„Най-доброто, разумно и просто обяснение на проблема за риска от изкуствения интелект, което съм чел.“ – Ишан Уонг, бивш главен изпълнителен директор на „Редит“

ЕЛИЕЗЕР ЮДКОВСКИ е един от основателите на областта на изкуствения интелект, която се занимава с разбирането на това как по-умните от човека интелекти мислят, как се държат и как преследват целите си. Като съосновател на нестопанската организация Machine Intelligence Research Institute („Институт за изследване на машинния интелект“, MIRI) Юдковски поставя началото на ранните научни изследвания по този проблем и изиграва важна роля в оформянето на обществения дебат за по-умния от човека изкуствен интелект. Включен в списъка на списание Time на 100-те най-влиятелни хора в областта на изкуствения интелект, Юдковски е една от дванадесетте публични фигури, представени в статията на „Ню Йорк Таймс“ Who’s Who Behind the Dawn of the Modern Artificial Intelligence Movement („Кой стои зад зараждането на съвременното движение за изкуствен интелект“) и един от седемте лидери на мисълта, представени в дискусията на „Уошингтън Поуст“ AI’s Rival Factions („Съперничещите си фракции в областта на изкуствения интелект“). Той изнесе реч на главната сцена на конференцията TED 2023 и е обект на дискусии или интервюта в „Ню Йоркър“, „Нюзуик“, „Форбс“, „Уайърд“, „Блумбърг“, „Атлантик“, „Икономист“ и много други медии.

НЕЙТ СОАРЕС е президент на MIRI. Работи в тази област от над десетилетие, след като преди това е натрупал опит в „Майкрософт“ и „Гугъл“. Соарес е автор на голям брой технически текстове и материали с технически елементи за съгласуването на изкуствения интелект, включително фундаментални трудове за изучаването на ценностите, теорията на вземането на решения и стимулите за търсене на власт в изкуствен интелект, който е по-умен от човешкия.

***

Елиезер Юдковски и Нейт Соарес: „Бяхме поканени да подпишем това отворено писмо от едно изречение в качеството ни на съпредседатели на Machine Intelligence Research Institute (MIRI, Институт за изследване на машинния интелект) – институт с нестопанска цел. MIRI работи по въпроси, свързани с машинния свръхинтелект, от 2001 г. – много преди тези проблеми да получат голяма публичност или финансиране. За да опростим нещата: сред малкото, които следят този въпрос от десетилетия, MIRI е признат за институцията, която работи по него най-дълго. Единият от нас – Юдковски, е основател на MIRI, а другият – Соарес, е настоящият му президент.

MIRI беше първата организирана група, която заяви: „Предвидимо е, че свръхинтелигентен ИИ ще бъде разработен в някакъв момент, и това изглежда изключително важно събитие. Може да е технически трудно да се композира свръхинтелектът така, че да помага на човечеството, вместо да ни вреди. Не трябва ли някой веднага да започне да работи по това предизвикателство, вместо да чакаме всичко да се превърне в мащабна извънредна ситуация по-късно?“

Не започнахме с изричането на това. Юдковски започна с опити да създаде машинен свръхинтелект през 2000 г. През 2001 г. обаче той осъзна, че машинният свръхинтелект няма непременно да се окаже приятелски. А през 2003 г. разбра, че проблемът ще бъде сериозен.

През първите две десетилетия от съществуването си MIRI беше технически изследователски институт без особено участие в политиката. Организацията приютяваше предимно семинари за заинтересовани учени и привличаше няколко обещаващи изследователи. Опитвахме се да се ориентираме в математиката, необходима за разбирането и формирането на свръхчовешкия машинен интелект, както и за прогнозирането как това може да се обърка.

MIRI имаше и някои ефекти надолу по веригата, към които сега се отнасяме противоречиво или със съжаление. Организирахме конференция, на която представихме Демис Хасабис и Шейн Лег – основателите на това, което по-късно щеше да стане Дийп Майнд на „Гугъл“, на първата им голяма финансираща организация. А Сам Олтман – главен изпълнителен директор на Оупън Ей Ай, веднъж заяви, че Юдковски „е накарал много от нас да се заинтересуват от изкуствения общ интелект (AGI)“ и „е бил от критично важно значение за решението да стартираме Оупън Ей Ай“.

Историята на MIRI е сложна, но един от начините да обобщим нашата връзка с по-широката област може би е следният: години преди да съществуват сегашните компании за изкуствен интелект, беше смятано, че предупрежденията на MIRI трябва да се отхвърлят, ако искаш да работиш по създаването на истински умен изкуствен интелект въпреки рисковете от изчезване.

Неотдавна, с началото на разцвета на ИИ, наблюдавахме с тревога как някои от по-новите хора, които създаваха ИИ компании, започнаха да говорят за изкуствен свръхинтелект като източник на огромни, изключителни сили. Сили, които те приеха, че ще контролират. Според много от тези основатели главната опасност беше, че неподходящи хора може да „притежават“ ИСИ. Те говореха за необходимостта да се спечели „надпревара във въоръжаването в ИИ“. Що се отнася до възможността не човек да „има“ ИСИ, а ИСИ да притежава ИСИ – т.е. единственият победител в надпреварата във въоръжаването с ИИ да бъде самият ИСИ: е, тези основатели не говореха за това.

Видяхме, че възможностите на ИИ растяха много бързо.

Видяхме, че областта на изследванията, в която бяхме ангажирани, насочена към разбирането на ИИ и към това да не тръгне по лош път, – напредваше много, много по-бавно.

Главоломната надпревара на компаниите за ИИ към свръхчовешки ИИ – усилията им да го създадат възможно най-бързо, преди конкурентите им да го направят – започна да ни изглежда като надпревара към дъното. Индустрията се носеше към катастрофа, и то катастрофа, която би влязла в учебниците като пример за това как не трябва да се занимаваш с инженерство. Само че никой нямаше да остане жив, за да напише анализа.

Вече не ни се струваше реалистично човечеството да може да се измъкне от катастрофата чрез проектиране и изследвания. Не при такива условия. Не навреме.

Отписахме предишните си усилия като неуспешни, прекратихме по-голямата част от изследванията на MIRI и пренасочихме фокуса на института към това да предадем предупреждението, което е в ядрото на тази книга:

Ако някоя компания или група, където и да е на планетата, създаде изкуствен свръхинтелект, използвайки нещо, което дори далечно прилича на сегашните техники, основано на нещо, което дори далечно прилича на сегашното разбиране за ИИ, тогава всички навсякъде по Земята ще умрат.

Не го казваме като хипербола. Не преувеличаваме за ефект. Смятаме, че това е най-пряката екстраполация от знанията, доказателствата и институционалното поведение около изкуствения интелект днес.

В тази книга излагаме аргументите си с надеждата да мобилизираме достатъчно ключови лица, вземащи решения, и обикновени хора, за да вземат ИИ на сериозно. Резултатът по подразбиране е смъртоносен, но ситуацията не е безнадеждна; машинен свръхинтелект все още не съществува и създаването му все още може да бъде предотвратено.

***

В ядрото си аргументацията на тази книга е ясна: създаването на машини, които мислят по-бързо и по-добре от човечеството, би засегнало света по-силно от всичко, което го е засягало досега. Създаването на свръхинтелигентни машини, изглежда, е проект, който ще е трудно да се реализира успешно. Ако погледнете как корпорациите и законодателите подхождат към този въпрос, не изглежда нещата да вървят в добра посока. Човечеството трябва да се оттегли. Не можем да изчислим кога ще настъпи катастрофата, но това не е същото като да знаем, че тя е много далече.

Останалата част от книгата (и онлайн допълненията) е тук само за да покаже, че тази ясна теза издържа при по-внимателно изследване.

Ако някой го развие, всички ще умрем.

Няма значение дали е построен от добронамерени, или от егоистични корпорации. Няма значение дали ще бъде построен от изследователи от Изтока, или от Запада. Няма значение дали ще бъде построен от безразсъдни оптимисти, или от хора, които казват, че уважават проблема. Никой не разполага с познанията или уменията да създаде свръхинтелект, който да изпълнява неговите заповеди.

В крайна сметка ни се струва, че това е вид бедствие, което е възможно да се предвиди. Ние изложихме аргументите си по най-добрия възможен за нас начин. Не сме се укрили зад „може би“, „риск“ и „възможно“. Опитахме се да представим защо прогнозирането на катастрофа е обосновано.

За да се пристъпи към действие въпреки всичко обаче, не би трябвало да е достатъчно да се докаже, че всичките ни конкретни причини за прогнозирането на катастрофа са погрешни. Ако изстреляте ракета и натоварите на борда ѝ цялото човечество, бихте искали да можете да прогнозирате, че няма да има катастрофа. Това е универсалният стандарт във всяка друга област на инженерството, от която зависи животът на хората. Не е достатъчно да сме сгрешили; трябва да сме сгрешили толкова, че да може да се прогнозира, че няма да има катастрофа.

Не е твърде късно човечеството да спре. Това няма да струва дори 1% от цената на войната и победата на Съюзниците във Втората световна война. Човечеството се нуждае само от осъзнаване на проблема и воля за живот.

Книгата „Ако някой го развие, всички ще умрем“, от Елиезер Юдковски и Нейт Соарес, можете да закупите чрез сайта на "Издателство Изток - Запад".